Cerramos aquí el ciclo iniciado en dos posts anteriores: «La rendición de cuentas: ese palabro…» y el post «La mutua rendición de cuentas: ilusión o realidad años después«, analizando las asimetrías en la rendición de cuentas.

Un tipo de rendición de cuentas olvidada es la “interna y de arriba a abajo”. La forma de gestionar la cooperación es diferente si se prima la rendición de cuentas sobre el aprendizaje. Intentar satisfacer la rendición de cuentas y el aprendizaje al mismo tiempo es difícil. Para observar las características diferenciales de la evaluación como aprendizaje o rendición de cuentas se recomienda Cracknell (2000:57).

Siendo la rendición de cuentas necesaria, no es lo mismo un enfoque de seguimiento y evaluación centrado en satisfacer a otros agentes de los que dependes y a los que rindes cuentas, que centrarse en primar más el aprendizaje de las lecciones para mejorar el desempeño (Cassen, 1985 en Cracknell, 2000). La primera, la rendición de cuentas, tiende a mirar hacia el pasado y a buscar errores, mientras que el segundo, el aprendizaje, tiende a basarse más en la crítica constructiva hacia el futuro. Sin embargo aunque la información resultante en cada una de estas orientaciones puede no ser utilizable en la otra (Binnendijk, 1999), se puede llegar a un equilibrio o compromiso en el que la exigencia de rendición de cuentas puede implicar aprendizajes y el aprendizaje puede llevar asociado la rendición de cuentas. De esta forma aprendizaje y rendición de cuentas son dos caras de una misma moneda que, bien utilizada, sirve para mejorar la organización.

La Declaración de París indica que “una de las mayores prioridades para países socios y donantes es ampliar la rendición de cuentas y la transparencia en la utilización de los recursos para el desarrollo” (2005). Para ello, señala que “los donantes se deberían comprometer a proporcionar información transparente y completa en tiempo oportuno sobre los flujos de la ayuda con el objetivo de que las autoridades de países socios puedan presentar informes presupuestarios completos a sus parlamentos y ciudadanos. Asimismo tanto donantes como socios se deberían comprometer a evaluar conjuntamente los avances de la implementación de los compromisos acordados sobre la eficacia de la ayuda al desarrollo, incluidos los compromisos de cooperación.

O´Donelll (1999 en Toledano et al., 2008:17) distingue entre rendición de cuentas horizontal (RCH) y vertical (RCV). La rendición de cuentas horizontal es la relación entre iguales de control entre agencias del estado, y la rendición de cuentas vertical es la relación entre desiguales (superior-subordinado o principal-agente) y de control de la sociedad hacia el estado. Los mecanismos de rendición de cuentas vertical se refieren a

(1) la rendición de cuentas electoral o

(2) la rendición de cuentas social o capacidad de los subordinados y de la sociedad para vigilar, interpelar y sancionar a los superiores si no cumplen con las normas.

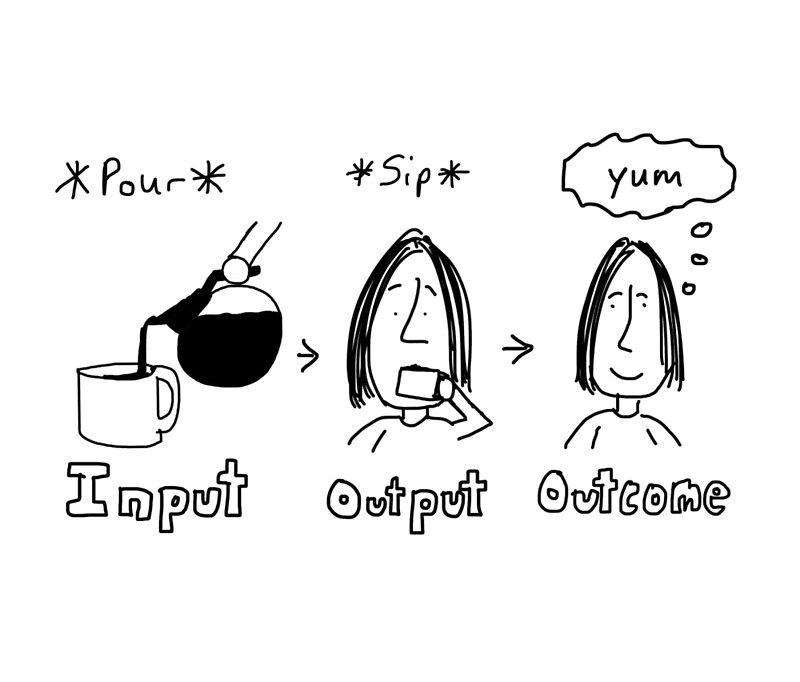

El mecanismo más común de rendición de cuentas hacia los donantes, por medio de informes de seguimiento o finalización y evaluaciones ex-post, sirve sobre todo para propósitos funcionales porque se centran en la rendición de cuentas de los fondos y en medir impactos de corto plazo. Sin embargo la rendición de cuentas de las ONGD hacia los donantes debería ser más flexible e innovadora, y se podría realizar, en la práctica, no sólo a través de informes, evaluaciones y valoraciones del desempeño, sino también a través de la puesta en valor de la participación (como un fin y medio de desarrollo), por medio de la auditoría social (que se basa en la rendición de cuentas entre organizaciones y gentes) y la autorregulación (a nivel de sector). Cada uno de estos últimos mecanismos se distingue por sus herramientas, sus procesos, el tipo de rendición de cuentas (hacia arriba, hacia abajo, interna, externa, funcional y estratégica).

Como indica Ebrahim (2003) la rendición de cuentas en la práctica ha priorizado los aspectos “externos y de abajo a arriba”, mientras que los mecanismos “internos y de arriba abajo” no se han desarrollado al mismo nivel. Por tanto, los donantes y ONGD se han basado más en rendición de cuentas a corto plazo y funcionales, y no tanto en procesos estratégicos de largo plazo necesarios para el cambio político y social.

Aunque en principio los agentes de la cooperación utilizan los recursos de los donantes para alcanzar los objetivos tanto propios, como los de los donantes; los intereses de agentes (ONGD incluidas) y donantes pueden no coincidir, debido a:

(1) que cada uno pone mayor énfasis en determinados aspectos (por ejemplo unos en crecimiento, otros en pobreza…), o

(2) a diferentes horizontes temporales o

(3) a aspectos organizacionales (por ejemplo mientras que los donantes están preocupados por un alto desempeño al mínimo coste posible, otros agentes pueden interesarse más por una financiación continuada, por la minimización de esfuerzos o la diversificación de recursos).

Como no es realista ni racional que los donantes controlen de forma continua el desempeño de los agentes (como las ONGD), el resultado final es el de la asimetría de poder y de información: las agencias y departamentos donantes tienen el poder que les otorga la decisión sobre la financiación, pero las ONGD tienen más información de un contexto en el que resultados, objetivos específicos y generales son difíciles de observar y medir.

Conscientes de las limitaciones del seguimiento de gabinete, algunas agencias han tratado de desarrollar métodos o herramientas de control para hacerlo más realista. Sin embargo el aumentar los recursos para conseguir que las agencias tengan un seguimiento o control directo más estrecho de los agentes, puede ser adecuado desde la consideración de intervenciones muy grandes; pero no es eficiente en el caso de las intervenciones múltiples y pequeñas de las ONGD.

En cualquier caso la dicotomía rendición de cuentas / aprendizaje no está resuelta en la cooperación al desarrollo, siendo un problema estructural de difícil solución. Hay autores que indican que optar por ambos objetivos (rendición de cuentas y aprendizaje) no es posible (Smith, 1998 en Cracknell, 2000); otros indican que sí es posible tal combinación, y que el problema es la concepción simplista y unilateralista de la rendición de cuentas. Cada vez hay más voces que critican que entre los actores del Norte (sean estos ONGD o agencias/departamentos financiadores), en la práctica, predomina la rendición de cuentas de abajo a arriba. Así, para los donantes la principal preocupación es ejecutar según el marco normativo o como mucho medir “si mi ayuda ha tenido éxito” y en menos medida valorar “por qué sí/no obtuvimos resultados” o si el socio está creado las condiciones para el desarrollo. Hay que indicar la importancia de conseguir un equilibrio entre rendición de cuentas y aprendizaje en cada organización para optar por las bondades de cada uno de los enfoques: un desequilibrio hacia la rendición de cuentas cierra las posibilidades de abrirse al aprendizaje, pero un desequilibrio hacia el aprendizaje puede implicar una dramática flexibilidad en el caso de no conseguir ningún resultado.

Mientras que desde la Declaración de París y la Agenda de Acción de Accra cobra cada vez más fuerza la necesidad de agregar, a

(1) la tradicional percepción de la rendición de cuentas (hacia los donantes),

(2) la rendición de cuentas de los donantes hacia la sociedad civil (del Norte y del Sur) y hacia las ONGD y

(3) de las ONGD hacia los beneficiarios; otros autores indican que estas sugerencias no son realistas dada la asimetría de recursos y poder, por un lado entre donantes y ONGD, y por otro, entre beneficiarios y ONGD.

El hecho de que los mecanismos de rendición de cuentas de los donantes hacia los demás (acerca de aspectos como su democracia interna, legitimidad y capacidad) no se han desarrollado lo suficiente en ambos sentidos (de abajo arriba y de arriba abajo) contribuye a deslegitimar la validez del sistema de control de calidad de las actuaciones.

En otras palabras: ¿cómo pueden sentirse legitimados algunos actores para demandar aspectos como eficiencia, participación, transparencia o fortaleza institucional, cuando a nivel interno las decisiones de esos actores no son ni eficientes, ni democráticas, ni transparentes? Este contexto imperfecto contribuye a que las ONGD y agentes involucrados se esfuercen menos en conseguir legitimidad externa e interna, que en protegerse de las interferencias y del abusivo potencial de exigencia de cuentas emanado desde los donantes, o bien en sobrevivir en un entorno cada vez más competitivo y de transparencia selectiva, pero en el que, además, la competencia es imperfecta, al no basarse sólo en el impacto en el desarrollo de las ONGD, sino en otras cosas (como el éxito de la relación y financiación con donantes o del fundraising). Y es que, la cantidad no es sinónimo de calidad de la ayuda.

Aunque poco frecuentes, sin embargo, hay experiencias en las que las ONGD han reducido con éxito estas asimetrías para aumentar su influencia en los donantes, en la opinión pública e incluso para incentivar a su propio personal. Algunos mecanismos son, en primer lugar, la reducción de la dependencia extrema de unos pocos financiadores; y en segundo lugar, a través del uso estratégico de algunos de los recursos propios no necesariamente escasos, y con posibilidad de ser controlados por las ONGD (como información, aprendizaje, legitimidad, ética, profesionalidad, democracia y participación interna, reputación…). Claro está que esto conlleva un esfuerzo y una apuesta por dotarse de una legitimidad interna, una ética, un valor e incentivos no monetarios, una gestión organizacional, por desgracia no tan frecuentes en el entorno de la Cooperación al Desarrollo.

Referencias

Cracknell, B. E. 2000, Evaluating Development Aid. Issues, problems and solutions, Sage edn, Sage.

Ebrahim, A. 2005, NGOs and organisational change. Discourse, reporting and learning Cambridge University Press, New York.

Rodríguez-Ariza, C. (2009). La gestión de la información en organizaciones de desarrollo. Serie CECOD. Número 11

Toledano, J. M., Guimaraes, J., Illán, C., & Farber, V. 2008, Buenas prácticas en la cooperación para el desarrollo. Rendición de cuentas y transparencia, La Catarata, Madrid.